Gli hacker italiani contro Google

Fonte: webmasterpoint.org

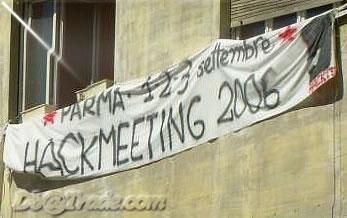

Chiuso a Parma l’HachIt 06, incontro annuale degli hacker italiani, quest’anno ha fatto scalpore la notizia in anteprima dell’uscita del libro The dark side of Google (Feltrinelli), un chiaro titolo per l’altrettanto chiaro intento; dimostrare il lato oscuro di Google…

Gli hacker italiani si sentono ingannati dal modello Google, più una moda per l’utente e uno sfruttamento intensivo dei dati forniti dagli utenti più che un sistema/strumento di ricerca, d’accordo le pubblicità ma l’invasività risulterebbe essere molto profonda:

La denuncia che parte dall’hackmeeting italiano parte dalla storia del motore, delle decisioni strategiche e di business dei suoi fondatori e manager fino ad arrivare alla critica della tecnologia e della programmazione su cui si fonde affermando che solo il 20-30% delle pagine web è indicizzata e considerata da Google. Non solo: i risultati che appaiono nelle prima pagine non sono i migliori possibili e spesso non sono adeguati alle ricerche che vengono fatte, ma, secondo gli autori del libro, la gente si accontenta, si adegua a Google stesso ritenendo, grazie al mito che vi aleggia intorno, che google sia il miglior modo per ricercare online. In qualche modo, si vuol affermare che Google, nella visione dell’utente medio, è internet stesso: quello che fa vedere Google, quei siti che indicizza Google sono internet. Il resto (di internet) non esiste.

Le affermazioni e le posizioni vanno rispettate, nulla di più bello che avere un confronto diretto tra le parti, immaginare un prossimo HachMeeting in presenza anche di esponenti di Google e degli altri motori di ricerca… è un idea!

Bisognerà leggere il libro, obbiettivamente ci saranno delle verità e tra queste; le persone, il business è anche sapere accontentare le persone e Google ai suoi utenti li accontenta, un numero così tanto elevato di accessi/secondo è un dato di fatto. Che non tutto sia trasparente e che la politica di riservatezza e rigidità applicata già all’interno della stessa struttura Google, ha dato dei notevoli risultati, che non ci sia la tutela dei dati degli utenti… lo si sà.

Per l’affermazione fatta nella citazione prelevata dal testo originale di webmasterpoint, se il solo 20/30 % delle pagine web è realmente indicizzata e considerata da Google, il dato deve fare riflettere, molto è cambiato anche con Sitemaps per migliorare e pulire gli indici, non ci risulta che a voler cambiare un sistema sia poi così tanto facile, Orion è ancora sperimentale e i diversi risultati ottenuti dai datacenter, visualizzazioni diverse ecc… fanno comunque vedere uno motore di ricerca in evoluzione, quanto meno, sembra.

E’ vero che un sito non indicizzato da Google non esiste, le statistiche di accesso ai siti lo dimostrano attestando una media mensile del 60% degli accessi totali, MSN e Yahoo lontanissimi da tali risultati; le possibili responsabilità?

Anche i SEO non sono esenti, spam violento e inutili sistemi hanno portato inevitabilmente a sporcare gli indici di ricerca e questo a sfavore degli utenti e anche dei clienti, escogitare sistemi per aumentare il fattore di pagerank, raccolta siti, varie gare di posizionamento, hanno anche questo effetto “riempitivo” inutile degli indici e delle pagine da certificare dal motore, gli hacker italiani non dovrebbero dimenticare che si è anche utilizzatori di sistemi e loro “esperti di informatica” sanno che non tutti sono eticamente corretti.

I motori concorrenti diretti hanno troppo poca popolarità e un numero molto più modesto di risultati, anche le statistiche dei siti web comunque lo dimostrano, una politica di advertising diversa potrebbe aumentare notevolmente gli accessi e le conversioni oltre che il numero di utilizzatori se… la pulizia degli indici e le attinenze di ricerca fossero rispettate.

Ci piacerebbe sapere dei motori semantici, un accordo W3C e i motori di ricerca per dare qualità ai sistemi di realizzazione web e di ricerca delle informazioni, attenzione, informazioni e non siti; Orion è un sistema che ancora non abbiamo visto in funzione ma che dovrebbe, in teoria, valutare l’originalità e la qualità dei contenuti e determinare le valenze e il posizionamento offrendo nel suo indice “informazioni” tratte dai siti web. Resta da vedere come funzionerà e in che modo potrà definire un sito di qualità; anche i siti spam, in tanti casi, sono dei siti di alta qualità di codice, di pagine, di PR…

Non siamo convinti che i futuri posizionamenti saranno influenzati dalla link popularity, dal PR ecc… non sarebbe male se i SEM e i SEO offrissero anche un servizio di “garanzia qualitativo” agli utenti e al mezzo di guadagno, i motori di ricerca…

La verità dove sarà?

Alex

Barche classiche e d'epoca

Barche classiche e d'epoca

Lascia un Commento

Vuoi partecipare alla discussione?Sentitevi liberi di contribuire!